En la actualidad existen muchas empresas que aún

poseen Bases de Datos 10g, 9i, incluso hasta 8i. Uno de los principales motivos

por el que aún no han migrado a una versión más reciente es por problemas de

aplicativo, presupuesto, hardware, entre otros. Sin embargo, es necesario tomar

en cuenta que mientras más avance el tiempo más difícil será mantener versiones

anteriores. Para hacer conciencia al respecto veamos lo siguientes datos

interesantes:

- Oracle anunció que ya no brindará soporte Premier de Bases de Datos versión 9.2 en Julio del 2007.

- Para clientes quienes están en versión 9.2, el Soporte Extendido finalizó en Julio del 2008.

- Para clientes quienes están en versión 10.1, el Soporte Premier finalizó en Enero del 2009.

- Para clientes quienes están en versión 10.2, el Soporte Premier finalizó en Julio del 2010.

Estos datos nos dicen que conforme el tiempo

avance, se hará más difícil encontrar soporte para problemas en versiones

anteriores. Esto implica más costo, vulnerabilidad a permanecer siempre con un

problema técnico debido a no encontrar soporte. Problemas para encontrar

parches, mal rendimiento, dificultad para innovar los productos, dificultad al

adoptar los cambios que el mercado exige.

Cuando se está considerando la migración de una

base de datos, la característica más atractiva es la adopción de las nuevas capacidades que la nueva versión proporciona. Es éste el objetivo del

presente artículo, darle a conocer algunas características importantes con las

que cuenta Oracle Database 11g que puedan proporcionarle a su empresa mayor eficiencia.

Las capacidades que trataremos en este artículo

son las siguientes:

- Nuevas capacidades que favorecen el cambio.

- Necesidades reducidas de almacenamiento.

- Fuerte aseguramiento de los datos.

- Mejor Rendimiento.

- Mayor Disponibilidad.

- Capacidades que mejoran la gestión de la base de datos.

- Fácil proceso de Migración.

Nuevas

capacidades que favorecen el cambio: La empresa constantemente está

presionada por nuevos cambios que exige el negocio, constantemente se están realizando

parchado de aplicaciones, comprando nuevo hardware y/o software para mejorar el

rendimiento pues cada vez la carga de trabajo aumenta, se tienen más clientes,

más transacciones, más volúmenes de datos, etc. Esto lleva a que el área de IT

constantemente esté testeando estas aplicaciones parchadas, hardware o

software, antes de poder trasladar o adoptar dichos cambios en producción. Sin

embargo, aunque se realice un testing intenso, pocos errores son detectados. La

mayoría de errores son finalmente enfrentados de manera reactiva cuando se

encuentra en producción, cuando se tiene la carga de trabajo real. Esto tiene

como consecuencia que se realicen mantenimientos no planificados, un mal rendimiento

o incluso hasta ventanas de tiempo sin servicio para poder corregir estos

errores. Todos estos problemas se traducen a perdida en la inversión que se

realizó para adquirir dichos cambios.

Oracle Real Application Testing combina capturas de

carga de trabajo en producción para replicarla con un analizador de rendimiento

SQL para ayudar a testear de manera más acercada a la realidad todos esos

cambios que la empresa constantemente está haciendo para poder tener un enfoque

competitivo ante el mercado. De esta manera, el tiempo de testing es reducido y

se aumenta la calidad del resultado obtenido.

Necesidades

reducidas de almacenamiento: En la actualidad, adquirir más capacidad de

almacenamiento se ha hecho mucho más fácil y su precio ha ido disminuyendo

considerablemente. Sin embargo, conforme el tiempo va avanzando la empresa cada

vez necesita tener disponibles volúmenes de datos más grandes. Paralelamente a

este crecimiento en datos debe de ir la escalabilidad y el rendimiento de las

aplicaciones, pues mientras más volúmenes de datos se estén manejando se

degrada el rendimiento.

Oracle Advanced Compression ofrece un conjunto de

capacidades de compresión de datos que pueden ayudar a la empresa a enfrentar

este crecimiento inevitable en los datos, de esta manera se reducirán los

costos en la adquisición de almacenamiento pues lo datos ocuparán menos

espacio. La compresión de datos también favorece el rendimiento, los datos

serán gestionados mejor en memoria debido a que los datos están en un formato compreso,

la red tendrá menos carga y se disminuirá las lecturas/escrituras. Oracle puede

comprimir los datos hasta en un 75% (o más) de su tamaño original.

Fuerte

aseguramiento de los datos: La empresa frecuentemente se enfrenta a la

necesidad de tener los asegurados los datos que se transfieren en la red, en

los respaldos que se realizan o dentro de la bases de datos como accesos no

autorizados.

Oracle Advanced Security provee una solución fácil con

la cual se protege toda comunicación entre la base de datos y quien la acceda,

proveyendo métodos de encriptación nativas y encriptación basadas en SSL.

Oracle Database Vault controla el quién, cuándo y dónde

los datos son accesados. Con esto la empresa está protegida de problemas de

seguridad que frecuentemente afectan la información que se maneja, como lo son

usuarios internos maliciosos o software malicioso.

Mejor

rendimiento: Oracle Database 11g ha tenido avances radicales en el tema de

rendimiento, gestionando mejor la memoria, los caches, la comunicación con la

aplicación cliente y ha mejorado la ejecución de sentencias SQL hasta en un

25%. Los PL/SQL han sido mejorados de una manera más dramática y pueden mejorar

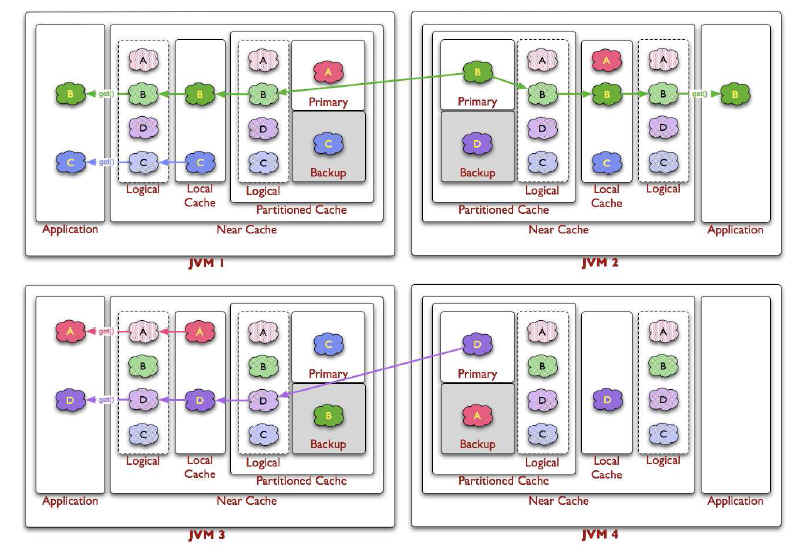

hasta en un 50% y en java hasta 11 veces más rapido. Oracle Real Application Cluster (RAC) también

ha incorporado muchas capacidades que mejoran el rendimiento. La recaudación de

estadísticas se ha hecho hasta 50% más rápida y más exacta en la información

que recauda. Se ha incorporado nuevos métodos de particionamiento que buscan

mejorar el acceso a los datos. La memoria ahora puede ser gestionada totalmente

de manera automática tanto la memoria asignada al SGA como al PGA, aliviando el

trabajo de administración que realizan los DBA’s.

Mayor

Disponibilidad: La creación de ambientes de contingencia para hacer frente

a los problemas que puedan producirse en la base de datos de producción se vuelve

cada vez más comunes. El ambiente de continencia también proporciona el

beneficio de poder aliviarle trabajo a la base de datos de producción sirviendo

como ambiente para ejecutar reportería o redireccionar un subconjunto de las

lecturas que la base de datos de producción realiza.

Oracle Activa Data Guard tiene la capacidad de

poder crear sitios de contingencia que pueden estar sincronizando los datos mientras

que puede estar abierta para lecturas y escrituras. De esta manera los datos

estarán a la fecha. Esta mejora es un hibrido entre una Physical Standby y una

Logical Standby que fueron incluidas en la versión 10g. En la versión 10g se

presentaba el problema que una Logical Standby podía ser abierta mientras

estaba sincronizando sus datos, sin embargo, no se soportaban todos los tipos

de datos, en la versión 11g este problema está solucionado.

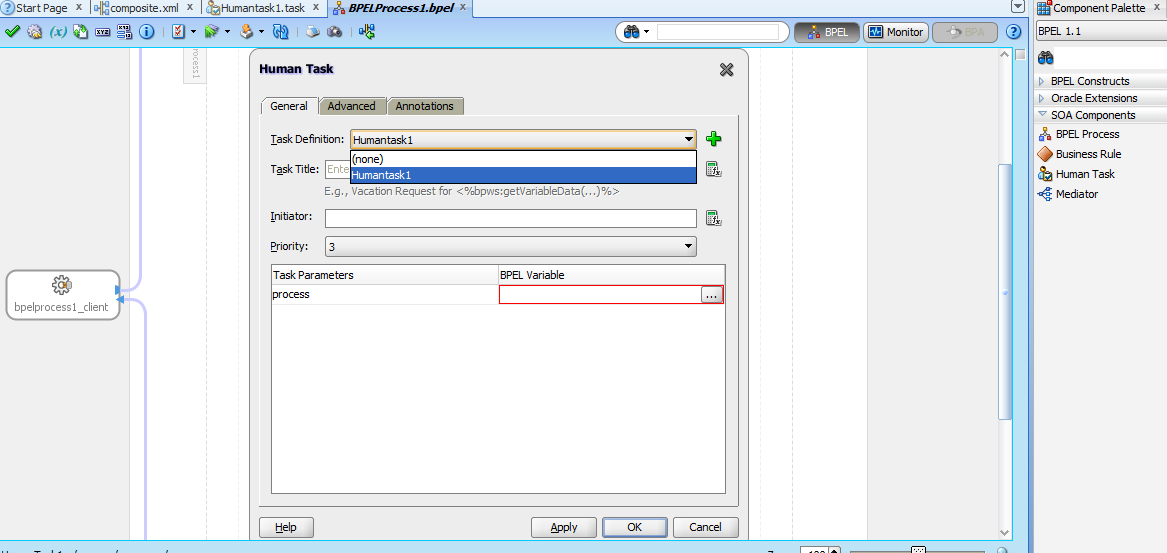

Capacidades

que mejoran la gestión de la base de datos: Administrar una base de datos

requiere un trabajo intenso y continuo de sus administradores, reduciendo así

la eficiencia de los mismos. En Oracle Database 11g se ha tratado de realizar

la mayoría de tareas automáticas, reduciendo la carga de los administradores y

aumentando así su eficiencia y su calidad de trabajo.

Algunas de las características en 11g son las

siguientes:

- Diagnostico de Monitoreo y diagnostico de rendimiento automático: Al realizar los diagnósticos de sistemas que están presenciando problemas de rendimiento se invierte muchas horas de trabajo intenso tratando de identificar la causa raíz. Existen muchas herramientas que ayudan al administrador proporcionándole gráficas y datos importantes, sin embargo, no dan soluciones puntuales. El Oracle Diagnostics Pack 11g realiza un diagnostico de los eventos que actualmente están influyendo en el mal rendimiento de un sistema y proporciona recomendaciones listas para ser ejecutadas en dicho ambiente con el objetivo de reducir el tiempo que se invierte en el diagnostico.

- Afinación de sentencias SQL: Ayuda a identificar aquellas sentencias SQL que están teniendo un mal desempeño y proporciona recomendaciones para mejorarlas, como reestructuración de la sentencia, creación de vistas, índices, etc.

- Enterprise Manager Database Console: Esta herramientas está capacitada en esta nueva versión 11g con más funcionalidades las cuales tienen como objetivo reducir el trabajo del DBA.

Fácil proceso de Migración: Oracle ha trabajado intensamente

en simplificar la operación de migración, mejorando radicalmente la herramienta

recomendada por excelencia: Database Upgrade Assistant (DBUA). El DBUA es una

herramienta gráfica que va guiando al administrador en todo el proceso de

migración, proporcionándole sugerencias, corrección de problemas, automatizando

ejecución de scripts, entre otros, con el objetivo que el proceso de migración

sea en su mayor parte automatizada. El DBUA tiene la capacidad de migrar bases

de datos sencillas (single instance), Real Application Clusters (RAC) y

Automatic Storage Management (ASM).

Sin embargo, no solo el DBUA existe para realizar

migraciones. Existen otros métodos de migración, los cuales, su elección

dependen de variables como: Sistema Operativo Origen, Sistema Operativo

Destino, Tiempo aceptado para tener el sistema abajo, versión de Base de Datos

origen, versión de base de datos destino, tamaño de la base de datos origen, entre

otros.

A continuación, algunos de estos métodos

adicionales:

- Exp/imp (export-import, herramientas antiguas).

- Expdp/impdp (export-import data pump)

- SQL Apply

- Manualmente

- Oracle Golden Gate

- Recovery Manager (RMAN)

Conclusión:

Tener una versión actualizada de nuestra Base de Datos no solo proporciona

ventajas en rendimiento, soporte, costos, manejabilidad, escalabilidad,

disponibilidad, sino que también ayuda a alcanzar al enfoque competitivo que

una empresa necesita para poder hacerle frente a las exigencias del mercado.